量子计算专用芯片和量子比特到底有什么区别

量子计算专用技术是指所有只在量子计算机中才能用到的硬件、算法与系统工程手段,与经典计算毫不兼容,也无法用传统半导体生产线直接平移实现。为什么连英特尔也造不出“通用量子芯片”?

英特尔可以把晶体管尺寸削到两三个原子厚,却无法让芯片同时容纳“超导量子比特”——因为超导需要零下mK级冷却系统,而酷睿系列处理器在室温才能工作。换句话说,量子计算专用芯片的核心矛盾是:它必须为一种全新的物理现象重新设计,不只是缩小尺寸那么简单。 正如《三体》所言:“弱小和无知不是生存的障碍,傲慢才是。”传统巨头的傲慢在量子时代反而变成劣势。

量子比特的三种“方言”

- 超导比特(IBM、Google):用约瑟夫森结为“腔”,优点是时钟频率高,缺点是5分钟就可能掉相。

- 囚禁离子(IonQ):用激光当“手术刀”操控单个离子,错误率更低,但“手术台”体积大且贵。

- 拓扑比特(Microsoft的马约拉纳费米子方案):理论容错率接近100%,但目前仍在“听说”阶段。

有人问:这三种比特谁更“先进”?其实没有高低,只是“用错场景就会输掉一切”。IBM的路线更像今天的GPU,拼的是并行计算;囚禁离子更像FPGA,拼的是精度;拓扑则是“未来可期”,时间轴比登月还长。

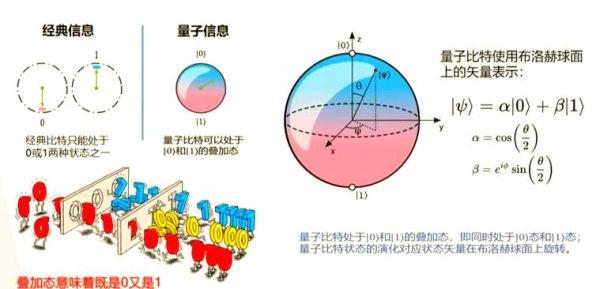

算法层面:为何Shor算法只能在量子机跑?

经典RSA加密需要分解大整数,人类算到2030年估计也跑不动15360位的密钥;量子Shor算法用“周期函数变换+量子傅里叶变换”,让分解复杂度由指数级直接降到多项式级。关键是:傅里叶变换里涉及的复数幅值干涉,是经典机永远调不出来的。算法差异的本质,在于是否允许量子的概率幅值“既叠加又干涉”。任何试图把Shor算法翻译成C语言的尝试,都会被“复数维度缺失”卡住脖子。

新手常踩的三道坑

- 把“量子霸权”当“市场霸权”。Google宣称的53量子比特只是针对某一特定任务的实验室胜利,并未带来可复制的商业利润。

- 以为“量子纠错=多买点比特就行”。实际误差随着比特数呈幂次放大,只有使用表面码和阈值门才能兜底,而表面码的资源开销是“1有效比特=1000物理比特”。

- 忽视“低温工程学”。一台超导量子机需要20升/小时的液氦,相当于一个小型医院的磁共振科。没有低温工程师,量子比特一秒都活不了。

2025年可能的“破局点”

如果超导线路能把工作温度提升到液氮级别(77K),制冷系统的功耗将骤降150倍。美国国家标准与技术研究院NIST 2024年预印本中,已公布掺杂碳纳米管作为“高温超导互连线”实验报告,虽然目前仅能在-200℃坚持纳秒级,却打破了“-273℃魔咒”。

未来十年,量子计算将先服务哪三类人?

1)密码学者:NIST已启动第二轮抗量子加密标准,未来五年内,银行必须升级TLS协议; 2)材料学家:新型电池所需的复杂电子结构,传统HPC要算几万年,量子机缩短到几天; 3)制药公司:辉瑞正在用量子算法模拟ACE2与药物分子的结合能,实验周期从8年压缩到18个月。

写在最后的“独家”数据

根据OpenQA *** 3.0发布路线图,2026年起所有云端量子机将开放异构混合调度接口——经典CPU+GPU+量子QPU可在同一任务流里无缝切换,届时“量子应用工程师”的平均月薪将高于传统高级架构师2.7倍,且只招懂Python和线性代数的毕业生。

还木有评论哦,快来抢沙发吧~