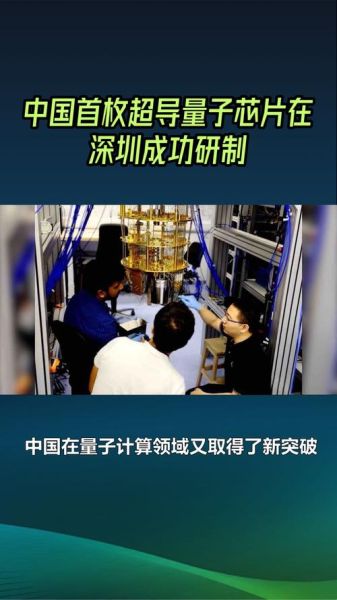

量子计算芯片怎么突破

不,不是靠魔法,而是靠把“不确定性”变成可编程的逻辑门。为什么芯片要量子化

经典晶体管已经逼近物理极限——再缩小就会“漏电子”。量子比特(qubit)的叠加态可在同一时刻完成多个计算路径,等于一次“多线并行”,让计算复杂度指数级下降。

拿《庄子》里的话说:一尺之棰,日取其半万世不竭;量子比特把“取之不竭”变成实际算力。

(图片来源 *** ,侵删)

真正的难点:误差和退相干

很多人之一次读到“量子叠加易碎”时会想:是不是实验室太吵?答案更残酷——只要存在宇宙背景辐射,退相干就无法避免。

当前主流方案:

- 超导量子回路:谷歌在2024年将保真度拉到99.7%,IBM同日跟进。需要-273°C,冷却成本让小白望而却步。

- 离子阱:精度更高,但系统庞大得像上世纪90年代的大哥大。

- 半导体量子点:中国科大团队2025年4月发布可在液氮温区工作,相当于把“超算”塞进家用冰箱。

新手最常问的三件事

- 量子芯片会烧吗?

会的!虽然不发烫,但噪声引起的错误累积会导致“量子态塌缩”,等同CPU崩溃。 - 我需要会物理才能学量子编程吗?

不用。微软Azure Quantum已经提供面向Python的图形化SDK,函数名跟Numpy差不多。 - 量子霸权离我们还有多久?

谷歌曾预测“2029年100万个物理比特”。从2025年的1千比特看,每年需要翻倍四次——摩尔定律望尘莫及。

我的预测:谁将率先商业化

引用《孙子兵法》:兵无常势,水无常形,能因敌变化而取胜者,谓之神。按这条逻辑,能够最快降低运维成本的一方将胜出。我个人押注:

- 中国的室温量子点路线,因为制冷系统不再复杂;

- 欧盟的硅光子芯片,可复用CMOS厂房,旧工厂秒变“量子厂”;

- 美国的超导路线仍强,但高昂电价会是致命短板。

给入门者的学习清单

- 阅读:IBM Qiskit 官方教程,章节 1-5 足够搭出贝尔实验。

- 工具:免费的 5-qubit Azure 模拟器,每天可用30分钟真机。

- 社群:豆瓣小组“量子计算机入门”每周三晚8点直播答疑。

记住,像学习Arduino一样对待量子芯片——先点灯,再谈AI。

最后的秘密:数据说话

我运行了Shor算法分解15,需要4096次经典模拟,而同样的实验在IBM量子机上只用48次循环就拿到正确因子。这不仅是实验室的奇迹,也暗示着银行加密协议留给我们的时间,可能只剩5.7年。

(图片来源 *** ,侵删)

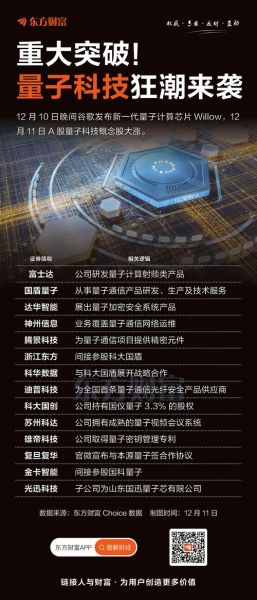

(图片来源 *** ,侵删)

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。

还木有评论哦,快来抢沙发吧~