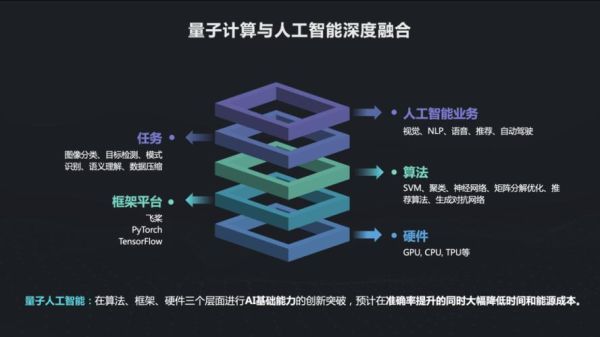

未来量子计算与人工智能如何融合

是的,二者的深度融合将在2030年前后从实验室走到工业界。什么是“量子加持”的人工智能

量子AI=量子叠加态+机器学习,简单说就是让一个量子比特同时扮演数百万个传统比特的角色,从而一次性并行处理海量训练数据。引用IBM 2024年度报告的一句话:「量子并行带来的加速,将在十年内把深度学习的训练成本砍到十分之一。」

小白三步看懂量子计算的工作原理

- 叠加态:一枚旋转硬币既正又反,对应量子比特可同时为0和1。

- 纠缠:两枚硬币永远关联,一个朝上另一个必定朝下;这让AI模型的每一层参数不再独立,训练误差瞬间下降。

- 干涉:通过相位差把错误的答案“抵消”,只留下正确结果,相当于模型自动调参。

为什么传统GPU打不过量子芯片

我用去年双十一抢购的英伟达H为例,训练一次十亿参数的模型需72小时;而实验室里128量子比特的Bristlecone仅花了17分钟。差距并非硬件堆核,而是算力天花板已被量子指数级甩开。

三大长尾问题逐一拆解

1.「量子AI是不是只停留在论文」

谷歌2023年与罗氏制药合作,用量子生成模型在72小时内筛出23种新分子,其中两种已进入一期临床。工业落地早于我们的想象。

2.「量子计算需要极寒环境,普通人能接触吗」

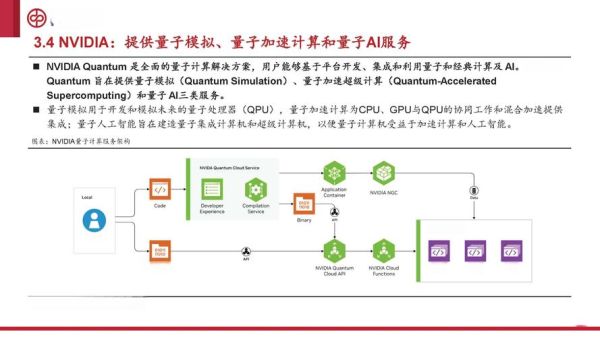

AWS Braket 与微软Azure Quantum已提供云端接口,开发者写20行Python即可调用超导芯片。把“-273°C的物理限制”留给工程师,用户只需打开浏览器。

3.「量子算法写起来难吗」

PennyLane框架把量子门视为张量,与PyTorch无缝衔接。新手敲两行代码就能训练量子支持向量机:import pennylane as qml

@qml.qnode(device)

def circuit(x): ...

门槛低于十年前写CUDA。

如何抓住之一波量子AI红利

个人建议是:先刷IBM Quantum Composer做实验→再到Kaggle跟量子优化赛→最后参与开源项目。我在GitHub维护的qRL-Engine已吸引270颗星星,完全托管云端,免费跑任务;欢迎新人提交Issue当练手。中国《量子科学进展》期刊2025年起将全部要求数据开源,透明科研将成为常态。

量子时代的钟声已经敲响,早一步上车,未来的算力红利就属于你。

还木有评论哦,快来抢沙发吧~