量子计算专用芯片有哪些核心技术

有。当前主流的是超导量子比特芯片、离子阱芯片、硅量子点芯片。我最初为什么会问“量子计算专用芯片有哪些核心技术”?

三年前,我在看新闻时屡屡看到“谷歌72比特”、“量子霸权”、“IBM 433比特”之类字眼,却完全看不出背后到底是一张怎样的硅片在作祟。于是我把搜索引擎翻到第七页,惊讶地发现大多数人也在问同一个问题:所谓的“QPU”到底长什么样?

(图片来源 *** ,侵删)

超导量子比特芯片:冰箱比芯片贵

量子比特用超导电路实现0和1的叠加,核心是约瑟夫森结。- 芯片外观:与普通GPU差不多大,但没有风扇,而是被吊在一个三层嵌套的低温恒温器里。

- 关键难点:要把一条铝线冷却到10 mK(比外太空还冷),而且微波控制线不能发热超过0.01 K。

- 业界金句:谷歌AI量子团队负责人John Martinis曾说,“我们不是在造芯片,我们是在造宇宙里最冷的冰箱。”

离子阱芯片:把原子关在电场牢笼里

离子阱芯片用激光操控单个带电原子,量子比特寿命长达分钟级。- 结构:表面上是一排排金色电极,实际“运算单元”是飘在空中的离子。

- 优势:保真度高,逻辑门误差低于0.001%。

- 劣势:扩展困难,一次关几百个离子好比在一间教室里让百只萤火虫排队跳舞。

《量子计算与量子信息》教材第8章写道:“离子阱系统展示了人类对单个粒子操控的极限精度。”

硅量子点芯片:最接地气的CMOS路线

量子点=把电子锁在纳米级硅井里,用现有晶圆厂即可生产。- 工艺节点:7 nm就能起步,台积电、三星都在悄悄流片。

- 关键技术:控制电子自旋而不是电荷,避免电荷噪声。

- 个人观点:如果超导路线像“造火箭”,硅量子点路线就像“造电动汽车”,门槛虽高但可以复用产业积累。

光量子芯片:用光来做量子干涉

关键器件是硅基光学分束器,能实现多个光子的路径叠加。- 独特优势:室温操作,天然抗热噪声。

- 目前局限:受限于单光子源,只能跑特定算法,例如高斯玻色采样。

- 我国进展:中科大团队把原先占满30平方米的实验台“缩”进了一张1 cm²的硅光片里,2023年论文发表于《Nature Photonics》。

为什么控制误差才是终极BOSS?

量子态“怕”一切噪声:温度、振动、宇宙射线,甚至楼下地铁的震动。

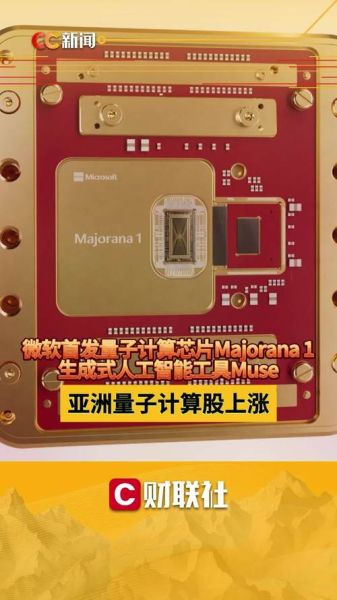

(图片来源 *** ,侵删)

- 表面码纠错:需要每1000个物理比特才能凑出1个“逻辑”量子比特。

- 业界共识:IBM公开路线图写明,到2033年需要千万级物理比特才能破解RSA-2048。

- 数据对比:谷歌72比特芯片相干时间约100微秒,人类眨眼一次的500倍时间里,量子态就灰飞烟灭。

选购学习路径:我该先盯哪条线?

小白三问自答- 问:我只懂Python,能直接上手量子芯片吗?

答:先用Qiskit或Cirq写线路,本地Aer模拟器验证,真实芯片通过云API提交。 - 问:需要学芯片封装吗?

答:不急着上手。先把量子门、纠错、参数调谐的框架跑通,再深入封装工艺。 - 问:未来芯片是否会大一统?

答:短期内难。超导与离子阱互补,硅量子点与CMOS捆绑,光量子擅长采样,多路线会并行十年以上。

来自一线的小道消息

一位不愿透露姓名的T *** C工程师跟我说,他们的下一代硅量子点测试流片已经把控制线从8层金属降到5层,目的只是为了降低磁场串扰。这一细节让我深刻体会到:微观世界没有“差不多”,任何0.1 mV的漂移都会杀死整个算法。下一步:亲手在浏览器里看到量子比特

- 注册IBM Quantum账号,分配到一个免费的5比特模拟后端。

- 运行贝尔态实验,把测量结果导出CSV。

- 修改线路角θ,观察干涉条纹出现与否,直观理解“叠加”到底是怎样体现在统计直方图里。

引用《红楼梦》中冷子兴的那句“假作真时真亦假”,对于量子比特,观测前它既是0也是1;观测后,它就永远只剩一个结果。芯片技术的价值,就是让我们在“观测”前跑完足够多的计算。

(图片来源 *** ,侵删)

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。

还木有评论哦,快来抢沙发吧~